一个Windows操作系统能够使用的pythonIDE

winPython下载地址:WinPython_2.7

传统的F-measure或平衡的F-score (F1 score)是精度和召回的调和平均值:

$$F_1 = 2 \times \dfrac{precision \times recall}{precision + recall}$$

1.Cross Validation (交叉验证)

cross validation大概的意思是:对于原始数据我们要将其一部分分为train_data,一部分分为test_data。train_data用于训练,test_data用于测试准确率。在test_data上测试的结果叫做validation_error。将一个算法作用于一个原始数据,我们不可能只做出随机的划分一次train和test_data,然后得到一个validation_error,就作为衡量这个算法好坏的标准。因为这样存在偶然性。我们必须好多次的随机的划分train_data和test_data,分别在其上面算出各自的validation_error。这样就有一组validation_error,根据这一组validation_error,就可以较好的准确的衡量算法的好坏。

cross validation是在数据量有限的情况下的非常好的一个evaluate performance的方法。而对原始数据划分出train data和test data的方法有很多种,这也就造成了cross validation的方法有很多种。

sklearn中的cross validation模块,最主要的函数是如下函数:

sklearn.cross_validation.cross_val_score:他的调用形式是scores = cross_validation.cross_val_score(clf, raw_data, raw_target, cv=5, score_func=None)

参数解释:

clf:表示的是不同的分类器,可以是任何的分类器。比如支持向量机分类器。clf = svm.SVC(kernel=’linear’, C=1);

raw_data:原始数据;

raw_target:原始类别标号;

cv:代表的就是不同的cross validation的方法了。引用scikit-learn上的一句话(When the cv argument is an integer, cross_val_score uses the KFold or StratifiedKFold strategies by default, the latter being used if the estimator derives from ClassifierMixin.)如果cv是一个int数字的话,那么默认使用的是KFold或者StratifiedKFold交叉,如果如果指定了类别标签则使用的是StratifiedKFold。

cross_val_score:这个函数的返回值就是对于每次不同的的划分raw_data时,在test_data上得到的分类的准确率。至于准确率的算法可以通过score_func参数指定,如果不指定的话,是用clf默认自带的准确率算法。

scikit-learn的cross-validation交叉验证代码:

1 | > from sklearn import cross_validation |

Note: if using LR, clf = LogisticRegression().

生成一个数据集做为交叉验证

1 | >>> import numpy as np |

将数据切分为训练集和测试集

1 | >>> X_train, X_test, y_train, y_test = train_test_split( |

交叉验证的使用

下面是手动划分训练集和测试集,控制台中输入下列代码进行测试:

1 | > import numpy as np |

下面是交叉验证的实例:

1 | >>> clf = svm.SVC(kernel='linear', C=1) |

通过cross_validation,设置cv=5,进行5倍交叉验证,最后得到一个scores的预测准确率数组,表示每次交叉验证得到的准确率。

1 | >>> print("Accuracy: %0.2f (+/- %0.2f)" % (scores.mean(), scores.std() * 2)) |

通过scores.mean()求出平均值,得到平均精度。还可以通过指定scoring来设置准确率算法

1 | >>> from sklearn import metrics |

libsvm格式的数据导入:

1 | > from sklearn.datasets import load_svmlight_file |

2.处理非均衡问题

对于正负样本比例相差较大的非均衡问题,一种调节分类器的方法就是对分类器的训练数据进行改造。一种是欠抽样,一种是过抽样。过抽样意味着赋值样例,而欠抽样意味着删除样例。对于过抽样,最后可能导致过拟合问题;而对于欠抽样,则删掉的样本中可能包含某些重要的信息,会导致欠拟合。对于正例样本较少的情况下,通常采取的方式是使用反例类别的欠抽样和正例类别的过抽样相混合的方法

3.scikit-learn学习SVM

1 | >>> from sklearn import datasets |

4.scikit-learn学习RandomForest

使用例子

1 | > from sklearn.ensemble import RandomForestClassifier |

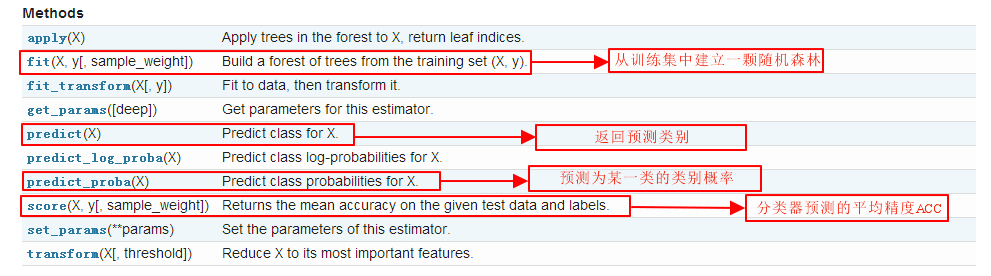

Method

randomForestClassifier分类器的初始值

1 | def __init__(self, |